- جایزه انجمن فیزیک ایران

- جایزه حسابی

- جایزه دبیر برگزیده فیزیک

- جایزه ساخت دستگاه آموزشی

- جایزه صمیمی

- جایزه توسلی

- جایزه علی محمدی

- پیشکسوت فیزیک

- بخش جوایز انجمن

اکرم میرحسینی

جایزه نوبل 2024 فیزیک، کارهای پیشگام در زمینه شبکه های عصبی مصنوعی را که پایه بسیاری از فناوری های هوش مصنوعی مورد استفاده امروز را فراهم کرده، گرامی می دارد.

برندگان نوبل فیزیک 2024، اولین شکل های هوش مصنوعی (AI) را با مدل سازی نورون ها در مغز توسعه دادند. این تصویر به وسیله هوش مصنوعی تولید شده است.

فرآیندهای معینی در مغز از قبیل شناخت و طبقه بندی می توانند به صورت برهمکنش های نورون های مصنوعی یا "گره ها" در یک شبکه به شدت به هم پیوسته مدل سازی شوند. این رویکرد الهام گرفته از فیزیک برای یادگیری انسان، لایق جایزه نوبل 2024 فیزیک شناخته شده است. جان هاپفیلد John Hopfield از دانشگاه پرینستون و جفری هینتون Geoffrey Hinton از دانشگاه تورنتو به طور مشترک جایزه امسال را برای کار خود در زمینه شبکه های عصبی مصنوعی که پایه بسیاری از فناوری های هوش مصنوعی از قبیل سامانه های تشخیص چهره و چت بات ها (ربات های مکالمه) شده، دریافت کردند.

یک شبکه عصبی مصنوعی، مجموعه ای از گره هاست که هریک از آنها دارای مقداری است که به مقادیر گره های متصل به آن وابسته است. در اوایل دهه 1980، هاپفیلد نشان داد که این شبکه ها می توانند با نوعی حافظه که قادر به تشخیص تصاویر از طریق یک فرآیند کمینه سازی انرژی است، مشخص شوند. بر مبنای این کار، هینتون نشان داد که چگونه جفت شدگی ها بین گره ها می توانند تنظیم شوند( یا "آموزش داده شوند") تا وظایف ویژه ای همچون مرتب سازی یا دسته بندی داده ها را انجام دهند. در مجموع، دستاوردهای این فیزیکدان ها شرایط را برای انقلاب یادگیری ماشین امروزی فراهم کرده است.

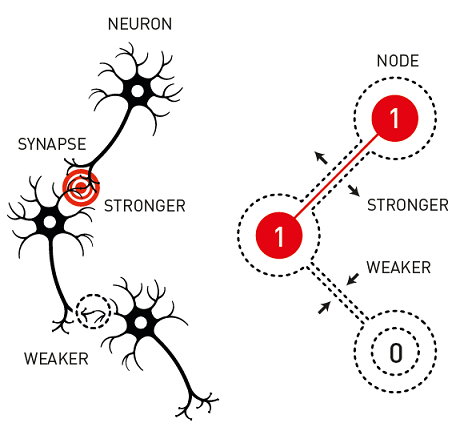

نورون ها در مغز با یکدیگر از طریق سیناپس ها ارتباط برقرار می کنند و تعداد سیناپس های متصل به هر نورون معین از یک محدوده انگشت شمار تا چندین هزار متغیر است. مطالعات اولیه در دهه 1940 نشان داد که فعالیت برانگیختگی یک نورون خاص-پالس های الکتریکی که تولید می کند- به ورودی های دریافتی از نورون های متصل بستگی دارد [1]. علاوه براین، نورون های متصلی که به طور همزمان برانگیخته می شوند می توانند ارتباطات متقابل قوی تری را گسترش دهند که سرانجام منجر به حافظه هایی می شوند که در قدرتهای سیناپسی مربوطه کد گذاری می شوند .[2] پژوهشگران بسیاری به باز تولید این رفتار عصبی در شبکه های دیجیتالی که در آنها گره ها با نورونها و جفت شدگی ها با سیناپس ها جایگزین شده اند، علاقه مند شدند. اما حل مسائل واقعی با این شبکه های عصبی مصنوعی از نظر محاسباتی چالش برانگیز بود.

نورونها در مغز از طریق سیناپسها به هم متصل می شوند. یک مدل معروف یادگیری به این صورت است که این ارتباطات بسته به فعالیت همبستگی دو نورون متصل، قویتر (یا ضعیف تر) می شوند. شبکه های عصبی مصنوعی بر این اساس ساخته میشوند که قدرت های اتصالات بین گره ها قابل تنظیم باشند تا یک نتیجه دلخواه تولید کنند.

در سال 1982، هاپفیلد راهی به جلو باز کرد [3]. او یک شبکه ساده بر مبنای سیستم های فیزیکی بس ذره ای مانند اسپین های اتمی درون یک ماده مغناطیسی پیشنهاد داد. در قیاس با یک شبکه عصبی، هر اسپین (یا گره) یک مقدار ویژه بر اساس جهت گیری خود دارد و این مقدار اسپین می تواند بر اسپین های مجاور از طریق برهم کنش های مغناطیسی (یا جفت شدگی ها) اثر بگذارد. این اسپین ها در یک پیکربندی پایدار، بر اساس قدرت برهمکنش ها مستقر می شوند.

با الهام گرفتن از فیزیک اسپینی، هاپفیلد یک شبکه از N گره متصل از طریق جفت شدگی های دارای وزن زیاد تشکیل داد. هر گره یک مقدار 0 یا 1 داشت که می توانست بر حسب مجموع وزنی همه گره های دیگری که با آن جفت شده (طی به روز رسانی های تصادفی) تغییر کند. او یک جمله "انرژی" بر اساس هم ترازی نسبی گره های متصل تعریف کرد و نشان داد که شبکه به سمت یک حالت کم-انرژی رفته است.

هاپفیلد سپس نشان داد که این شبکه عصبی بر پایه اسپین می تواند یک "حافظه" را در یکی از حالتهای انرژی پایین (پایدار) ذخیره و بازیابی کند. مثالی از دنیای واقعی، به خاطر سپردن یک الگو در یک تصویر است. در اینجا، گره های شبکه با پیکسل های روی یک صفحه نمایش مرتبط هستند و جفت شدگی ها به گونه ای تنظیم می شوند که خروجی (یا حالت پایدار) با یک تصویر هدف که ممکن است برای مثال حرف "J" باشد، مطابقت کند. اگر سپس شبکه با یک تصویر (ورودی) متفاوت -مثلا با یک حرف "J" خیلی به هم ریخته یا بد نوشته شده مقدار دهی اولیه شود، مقادیر گره به طور طبیعی تصویر را به حالت پایدار شبکه در می آورند. این فرآیند نشان می دهد که شبکه ورودی را با "J" ذخیره شده، یعنی الگو حافظه، مرتبط می کند.

استفاده های کاربردی شبکه هاپفیلد علاقه پژوهشگران دیگر از جمله هینتون را به خود جلب کرد. در نیمه دهه 1980، او و همکارانش یک شبکه به نام ماشین بولتزمن را توسعه دادند که در آن به هر پیکربندی گره ممکن یک احتمال بر مبنای انرژی آن نسبت داده می شود [4]. پژوهشگران الگوریتمی ابداع کردند که جفت شدگی های شبکه را به گونه ای تنظیم می کرد که توزیع احتمال با توزیع آماری در داده های هدف مطابقت کند. برای موثرتر کردن این روش، هینتون و همکارانش ایده لایه های "قابل مشاهده" گره ها را که برای ورودی ها یا خروجی ها استفاده میشوند و لایه های "پنهان" مجزا را که هنوز بخشی از شبکه اما نامرتبط با داده ها هستند، معرفی کردند. گونه ای از این طرح به نام ماشین بولتزمن محدود شده، به یک پیش نیاز برای شبکه های یادگیری عمیق تبدیل شد که ابزارهای مورد استفاده گسترده ای در زمینه هایی مانند علوم کامپیوتر، ایمنی شناسی و مکانیک کوانتومی هستند.

گیوسپ کارلئو Giuseppe Carleo، یک متخصص یادگیری ماشین از موسسه فناوری فدرال سوئیس در لوزان (EPPFL)، از ماشین های بولتزمن محدود شده برای پیدا کردن حالتهای پایه و تحول زمانی سیستم های کوانتومی پیچیده استفاده کرده است .[5] او می گوید هینتون و هاپفیلد زمینه را برای درک ماشینی از یادگیری فراهم کردند. کارلئو می گوید: "هیجان انگیز ترین قسمت برای من به عنوان یک فیزیکدان در واقع مشاهده شکلی از هوش ابتدایی است که از اصول اولیه از مدل های نسبتا ساده ای که می توانند با ابزار فیزیک تحلیل شوند، پدیدار می شود."

هینتون همچنین در توسعه "پس انتشار" برای آموزش شبکه های عصبی موثر بود. این روش شامل محاسبه اختلاف بین یک خروجی شبکه و یک مجموعه از داده های آموزشی و سپس تنظیم جفت شدگی های گره به منظور کمینه سازی این اختلاف است. این نوع از بازخورد جدید نبود، اما هینتون و همکارانش نشان دادند که افزودن لایه های پنهان می تواند مطلوبیت این فرآیند را گسترش دهد.

استفانی زیشک Stefanie Czischek کارشناس شبکه مصنوعی از دانشگاه اتاوا در کانادا می گوید: "جایزه نوبل امسال به دو پیشرو شایسته تعلق گرفته است." او می گوید کار هاپفیلد و هینتون نشان داد که چگونه اصول سیستمهای اسپینی می تواند بسیار فراتر از قلمرو فیزیک بس ذره ای گسترش یابد. زیشک می گوید: "اگرچه شبکه هاپفیلد و ماشین بولتزمن محدود شده هر دو با ساختارهای قویتر در اکثر برنامه های کاربردی جایگزین شده اند، اما آنها بنیان پیشرفته ترین شبکه های عصبی مصنوعی را بنا نهادند.

در طول سالها، شبکه های عصبی به مجموعه ای از الگوریتم های هوش مصنوعی تبدیل شده اند که چهره ها را تشخیص می دهند، ماشین ها را می رانند، سرطان ها را شناسایی می کنند، موسیقی می سازند و مکالمه ها را پیش می برند. در کنفرانس مطبوعاتی جایزه نوبل، از هینتون درباره تاثیر آتی هوش مصنوعی پرسیده شد. او گفت: "این تاثیری شگفت و قابل مقایسه با تاثیر انقلاب صنعتی خواهد داشت." او تصور می کند این تاثیر در برخی زمینه ها از قبیل خدمات درمانی مورد استقبال قرار خواهد گرفت، اما او همچنین درمورد احتمال تاثیر کنترلگری هوش مصنوعی بر زندگی هایمان، ابراز نگرانی کرد.

- W. S. McCulloch and W. Pitts, “A logical calculus of the ideas immanent in nervous activity,” Bull. Math. Biophys. 5, 115 (1943).

- D.O. Hebb, The Organization of Behavior (Wiley & Sons, New York, 1949).

- J. J. Hopfield, “Neural networks and physical systems with emergent collective computational abilities,” Proc. Natl. Acad. Sci. U.S.A. 79, 2554 (1982).

- D. Ackley et al., “A learning algorithm for boltzmann machines,” Cogn. Sci. 9, 147 (1985), https://www.sciencedirect.com/science/article/pii/S0364021385800124.

- G. Carleo and M. Troyer, “Solving the quantum many-body problem with artificial neural networks,” Science 355, 602 (2017).

Nobel Prize: Mimicking Human Intelligence with Neural Networks

ترجمه خبر: بهناز ساربانها

نویسنده خبر: مریم ذوقی

آمار بازدید: ۷۹۵

ارجاع دقیق و مناسب به خبرنامهی انجمن بلا مانع است.»

RSS

RSS